aiacademy: 深度學習 RNN 網路神經調教

為什麼LSTM 好訓練?

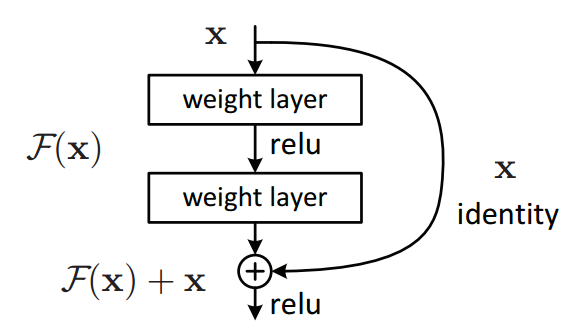

ResNet

調教之前的提醒

-

問個好問題

- 要解決的問題,當有不同的問法。通常第一次的問法都要調整,還有一定要考慮是不是有足夠的資料。

-

建構你的神經網路

初始化方法的選擇

-

其實基本上,weights 亂亂選就可以。

-

權重參數選取原則

- 不要全部設成 0

-

取小一點的值

-

activation initializer sigmoid, tanh Xavier ReLu He SELU LeCun

初始化的理論

|

|

|

|

|

不同參數初始化的方法

- Sigmoid, tanh

|

- ReLu

|

|

- SELU

|

Regularization 之 Dropout

|

Regularization

|

學習法改良的兩個方法

|

|

|

Momentum

|

|

|

Learning Rate變速器和Adam學習法

|

|

|

|

BatchNormalization

|

|

ResNet

|

|

|

RNN 可用 ResNet 嗎

-

- Muliti-head attention + GRU

SELU

- SeLU 就只是一個 activation function

|

|